Впервые в истории вышла модель преобразования текста в видео с открытым исходным кодом, и она, довольно, интересная.

Модель, которую можно опробовать на Hugging Face, обучена на 1,7 миллиарда параметров.

Например, посмотрите на это сообщение в Twitter, где некто по имени Victor M создал свой собственный клип на фильм «Звездные войны» с помощью этой модели.

Хотя текст в видео уже доступен, наш восторг немного приглушается водяными знаками Shutterstock. Однако это огромный прогресс, и скоро мы увидим еще более совершенные модели преобразования текста в видео.

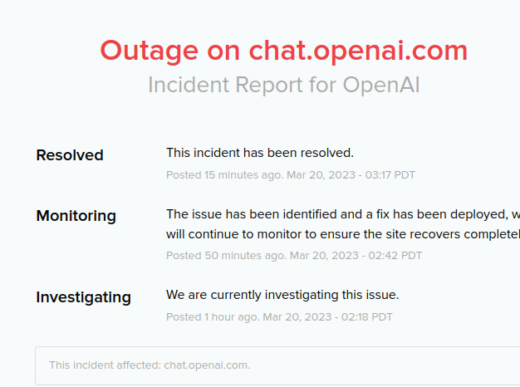

GPT-4 для большей доступности:

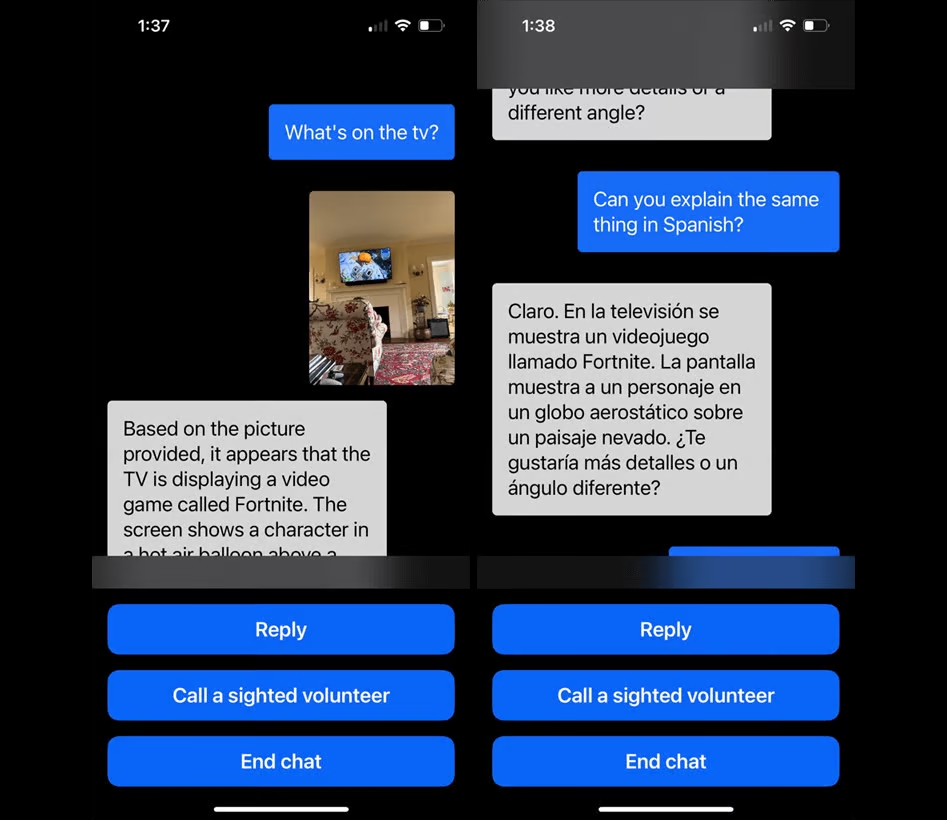

Приложение Be My Eyes, помогающее слепым и слабовидящим людям, только что добавило новую функцию «Виртуальный волонтер», интегрированную с генератором преобразования изображений в текст на основе GPT-4 от OpenAI.

В скором времени пользователи смогут отправлять изображения виртуальному волонтеру на базе ИИ для мгновенной идентификации, интерпретации и разговорной визуальной помощи при выполнении разных задач.

Мы связались с Майком Бакли, генеральным директором Be My Eyes (в переводе на русский «Будь моими глазами»), через Twitter, и он щедро поделился эксклюзивной информацией о текущем использовании модели преобразования изображений в текст на основе GPT-4:

Изображения, которые он нам прислал, были, мягко говоря, невероятными. GPT-4 смог распознать содержимое телевизионного экрана по небольшому уголку изображения и перевести его в реальном времени на другой язык.

Запишитесь в список ожидания Virtual Volunteer от Be My Eyes на их сайте здесь.